在学术界对人工智能生成论文高度关注的时代,堪萨斯大学传来了令人放心的消息。

研究人员开发了一种用于科学论文的人工智能文本检测器,几乎可以100%区分人类编写的内容和计算机生成的内容。

Heather Desaire 教授在11 月 6 日发表在《细胞报告物理科学》上的一项研究中指出,虽然目前有几种针对一般内容的人工智能检测器可用,但在应用于科学论文时没有一个特别好。

“大多数文本分析领域都需要一个真正通用的检测器,可以处理任何事情,”德赛尔说。相反,她的团队专注于专门为化学主题的 科学期刊撰写的报告。

“我们真正追求的是准确性,”她说。

该团队的探测器接受了美国化学会出版的期刊的培训。他们收集了 100 篇由专业人士撰写的介绍性段落,然后对 ChatGPT 进行编程,使其根据期刊摘要或仅根据报告标题编写自己的介绍。

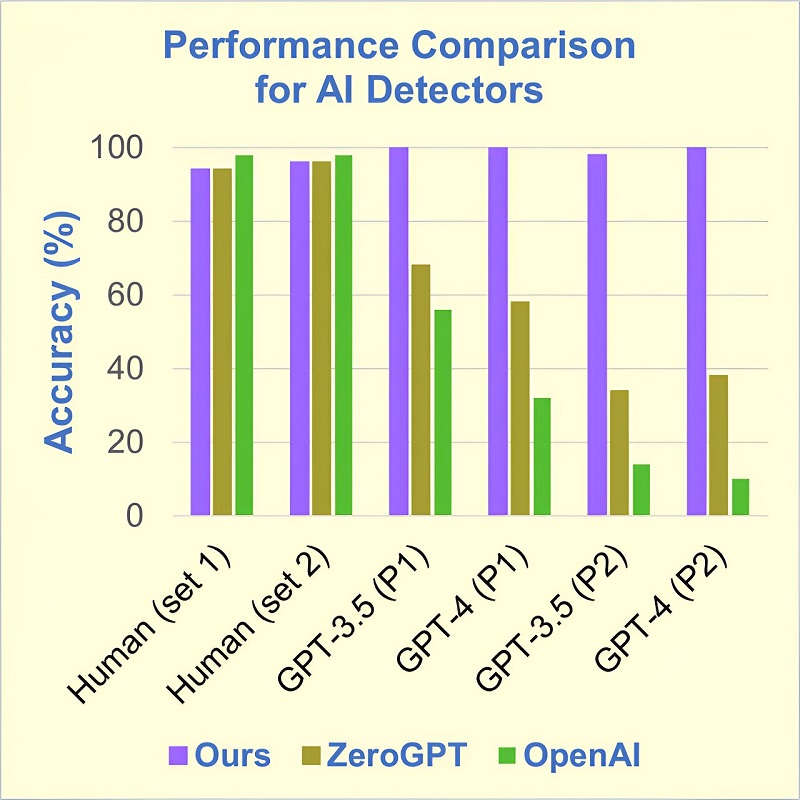

当 ChatGPT 检测器扫描三类报告时,它 100% 正确地识别出人工撰写的段落,以及根据仅包含报告标题的提示生成的报告。结果与依赖介绍性段落的报告几乎一样好,正确识别率高达 98%。

ZeroGPT 等竞争分类器在检测一般人工智能撰写的论文方面拥有 98% 的准确率,但在与化学相关的报告方面却表现不佳。对于基于标题的相同报告,它的平均准确率仅达到 37%,对于基于介绍性文本的报告也仅提高几个百分点。

第二个竞争对手 OpenAI 的表现更糟,平均 80% 的时间都无法正确识别论文的作者。

“学术出版商正在努力应对新的人工智能文本生成器的快速和普遍采用,”德赛尔说。“这个新的探测器将使科学界能够评估 ChatGPT 对化学期刊的渗透,确定其使用的后果,并在出现问题时迅速引入缓解策略。”

科学期刊正在重写有关文章提交的规则,大多数期刊禁止人工智能生成的报告,并要求披露撰写报告时使用的任何其他人工智能流程。

Desaire 列出了对人工智能生成的内容渗透到科学期刊的风险的几个担忧:“它们的过度使用可能会导致大量毫无价值的手稿出现。它们可能会导致被高度引用的论文被过度引用,以及尚未为人所知的新兴作品。” ,被忽略。”

“最令人担忧的是,”她补充道,“这些工具容易产生‘幻觉’,编造不真实的事实。”

作为说明,Desaire 引用了一个关于 ChatGPT 撰写的关于她的传记草图的结果的个人轶事。上面说她“毕业于明尼苏达大学,是英国皇家化学学会会员,并获得比曼奖章”。令人印象深刻的成就,但都是虚假的。

“虽然这个例子很有趣,”德赛尔说,“但用谎言渗透到科学文献中却一点也不有趣。”

但她仍然保持乐观。她说,有人说抵制人工智能生成内容的出现是不可避免的,他们认为“开发这样的工具正在参与一场人类不会获胜的 军备竞赛(针对人工智能)。”

她说编辑必须带头检测人工智能污染。

她说:“期刊应采取合理措施,确保其有关人工智能写作的政策得到遵守,我们认为在检测人工智能问题上保持领先是完全可行的。”